ChatGPTを使いたいけど、会社で使うとセキュリティが心配という方向けに、ローカルで使用できるAPIがOpenAIからリリースされ、それを使うためのアプリが出始めています。以前の記事ではLM-studioを紹介しましたが、今回はOllamaとOpenWebUIを活用して、構築したいと思います。

環境

・Windows11

・NVIDIA GeForce RTX 4070 SUPER

・Python v11.8(Open-webUIがPythonのバージョン11を推奨)

セットアップ手順

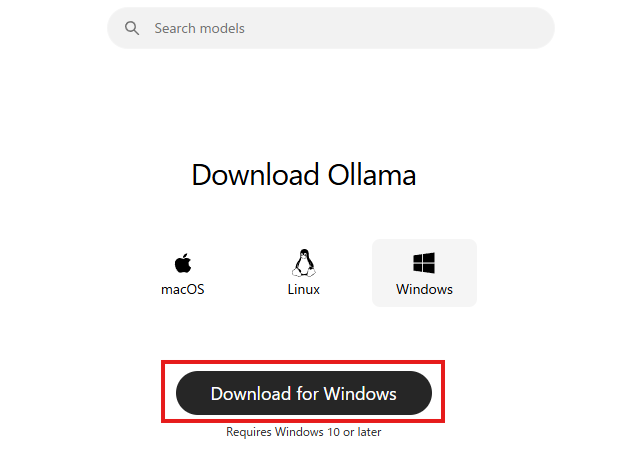

まずはOllamaをインストールします。次のサイトから、Windows向けをダウンロードしてください。

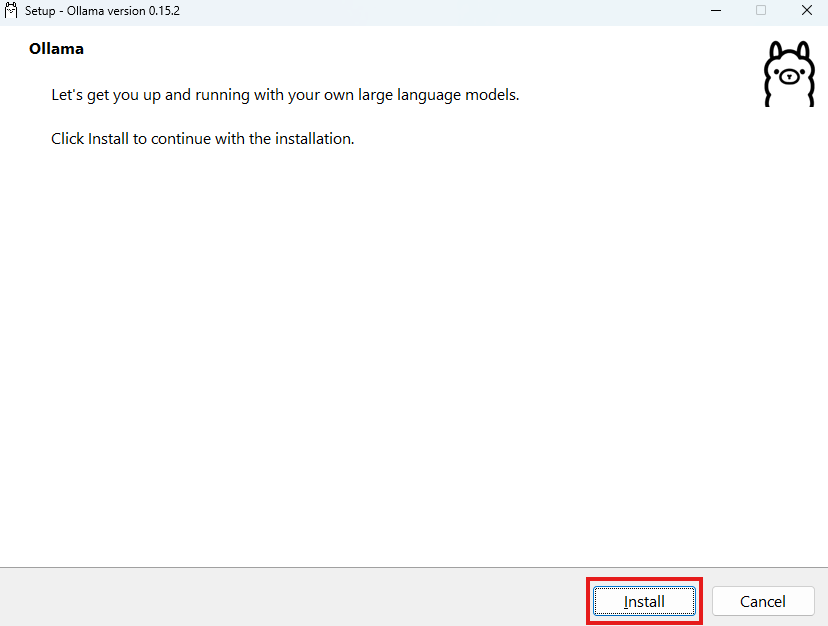

ダウンロード後のexeファイルを実行

インストール

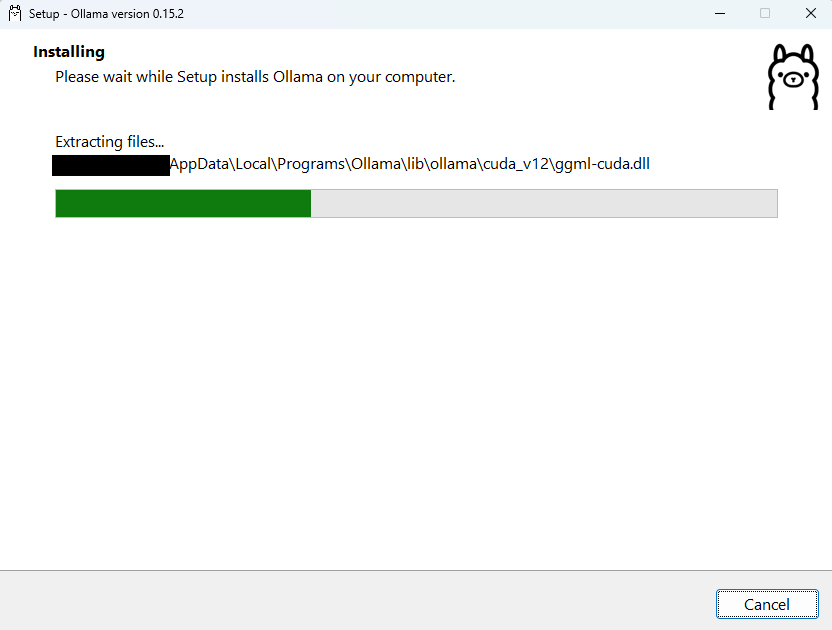

インストールされます

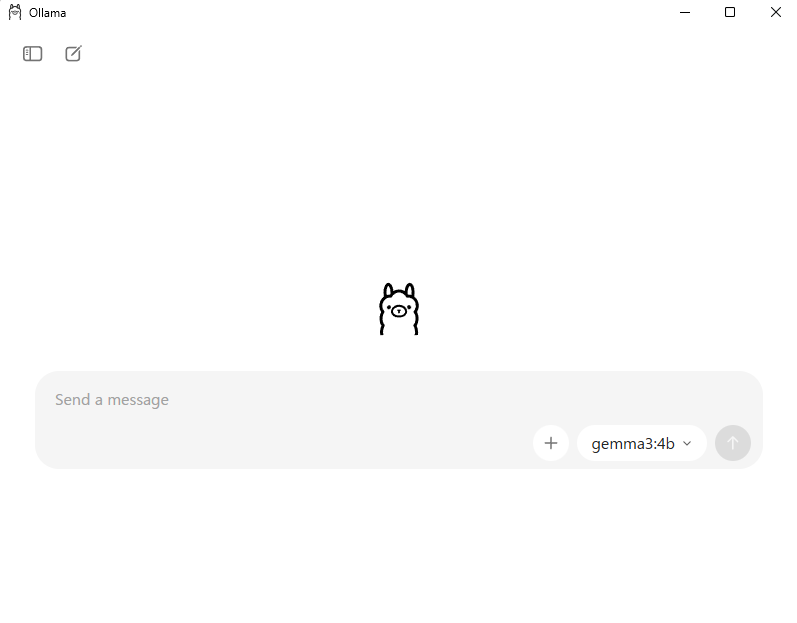

するとすぐにこのように起動します。

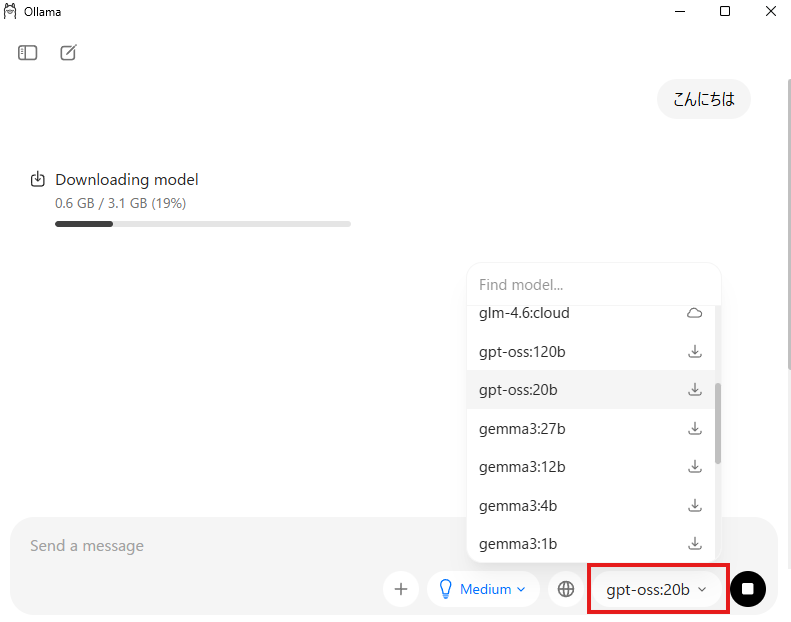

ここでモデルを選択して、何かチャットすると、モデルのダウンロードが始まります。

ダウンローが完了すると、このように回答してくれます。

Open-WebUIの準備

Python仮想環境作成

次にOpen-WebUIをインストールします。仮想環境を使った方が安全なので、仮想環境を作ります。

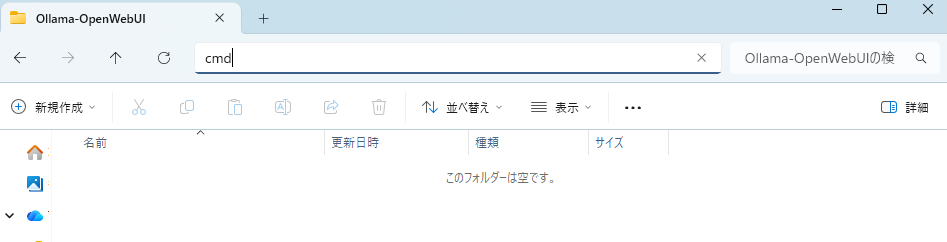

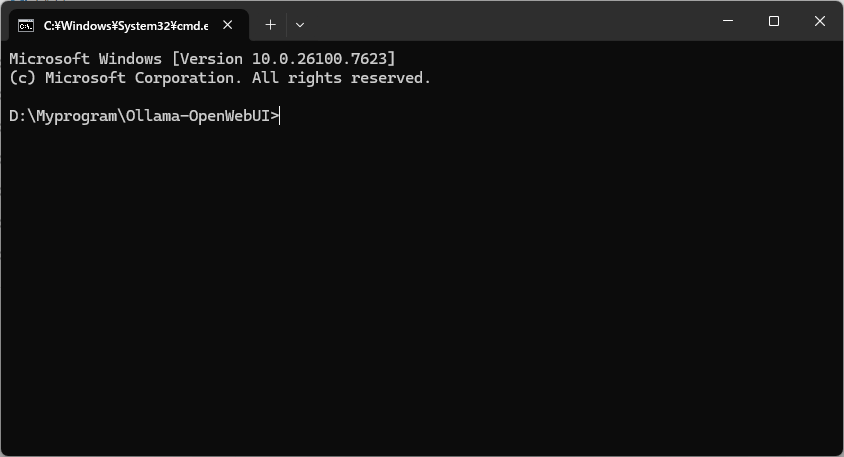

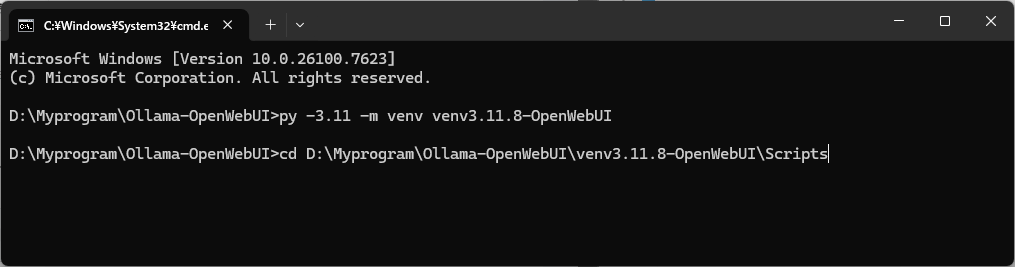

まずはコマンドプロンプトを立ち上げ、環境を作りたいディレクトリに移動します。ここでは、「D:\Myprogram\Ollama-OpenWebUI」に作る事にします。

コマンドプロンプトは、仮想環境を作りたいパスまで行って、アドレスバーに「cmd」と打つと、そのパスが設定されたコマンドプロンプトがでるので便利です。

このコマンドプロンプトで下記コマンドを入力

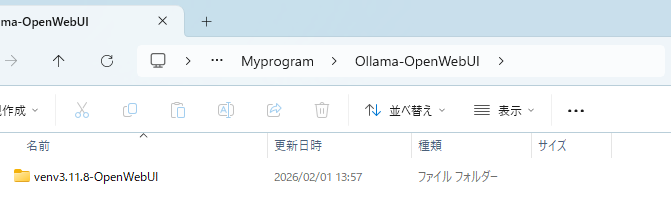

py -3.11 -m venv venv3.11.8-OpenWebUIそうすると、該当のフォルダに下記フォルダが出来上がってます。

フォルダに入ると、「Script」フォルダがあるので、その階層にコマンドプロンプトで移動

cd D:\Myprogram\Ollama-OpenWebUI\venv3.11.8-OpenWebUI\Scripts

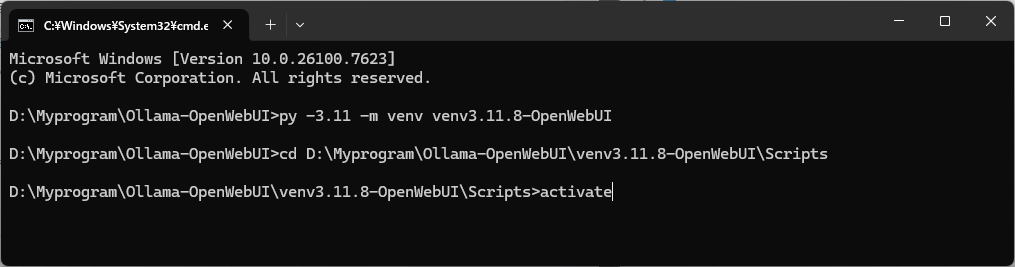

activateします。

activate

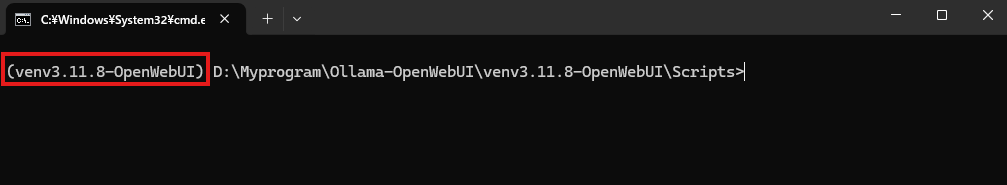

↓の赤枠のように仮想環境の名前が出ていればOK

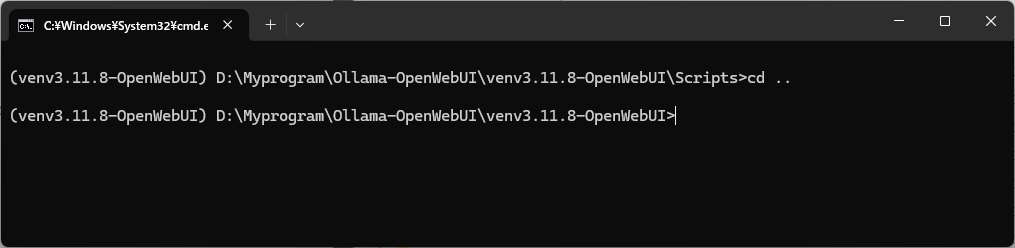

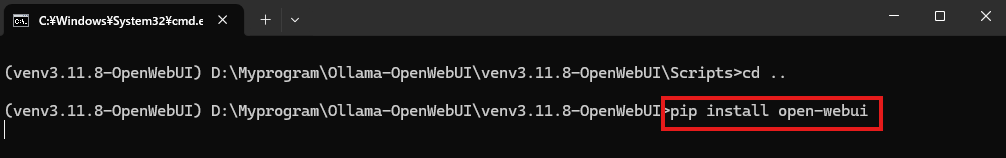

次のコマンドで階層を1つ戻します

cd ..

OpenWebUIのインストール

仮想環境でOpenWebUIをインストール

pip install open-webui

しばらくすると完了します。

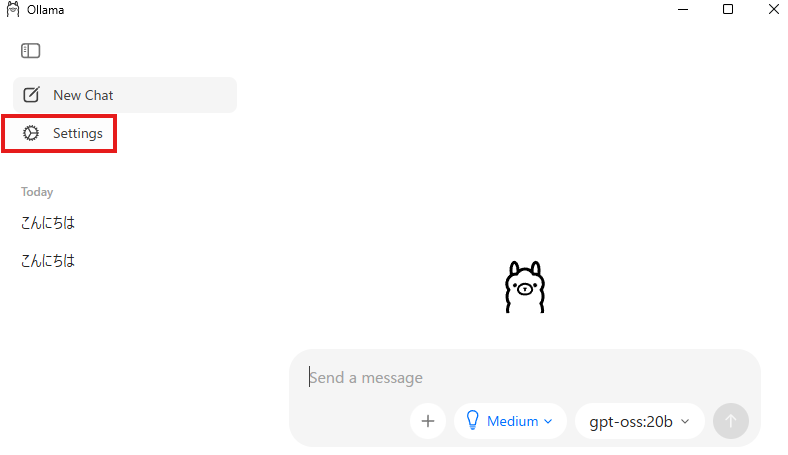

Open-WebUIからOllamaを操作

それでは、Open-WebUIからOllamaにせつぞくします。まずはOllamaのセッティングを変更。下記赤枠をクリック。

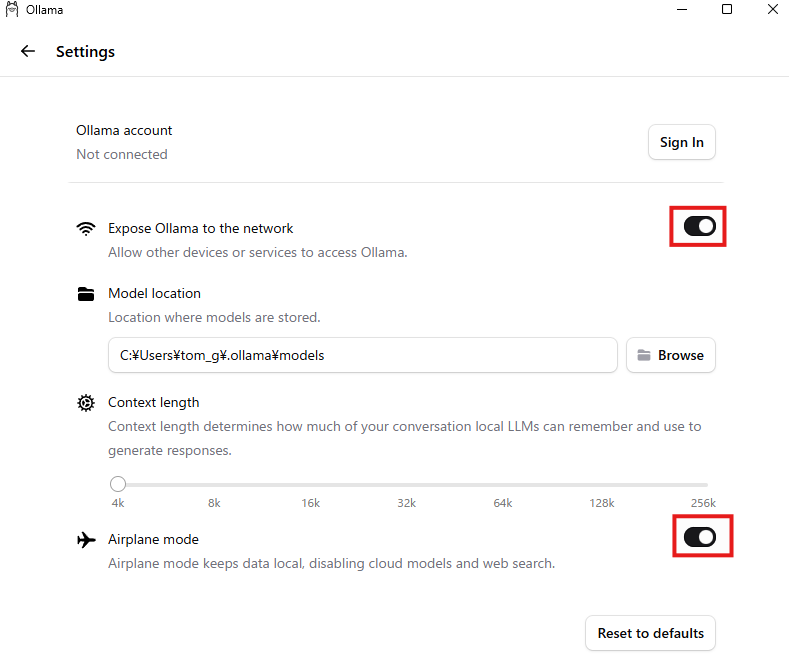

下記の赤枠をどちらもON

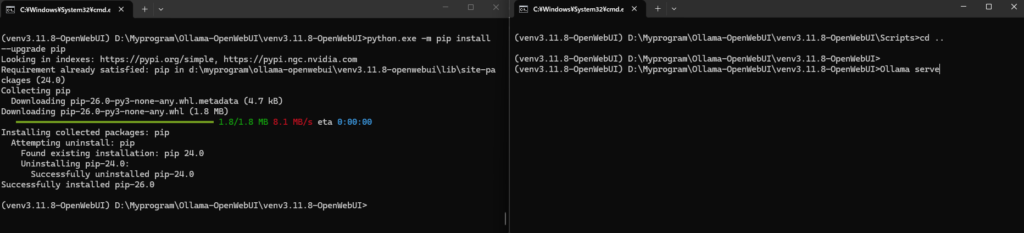

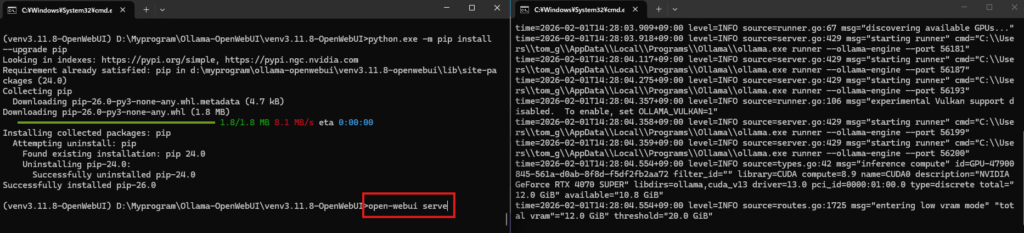

仮想環境のコマンドラインをもう1つ立ち上げます。

左がOpen-WebUI用、右はOllama用

まずはOllamaを起動するため、次のコマンドを入力。

Ollama serve

次はもう1つのコマンドラインでOpen-WebUIを起動

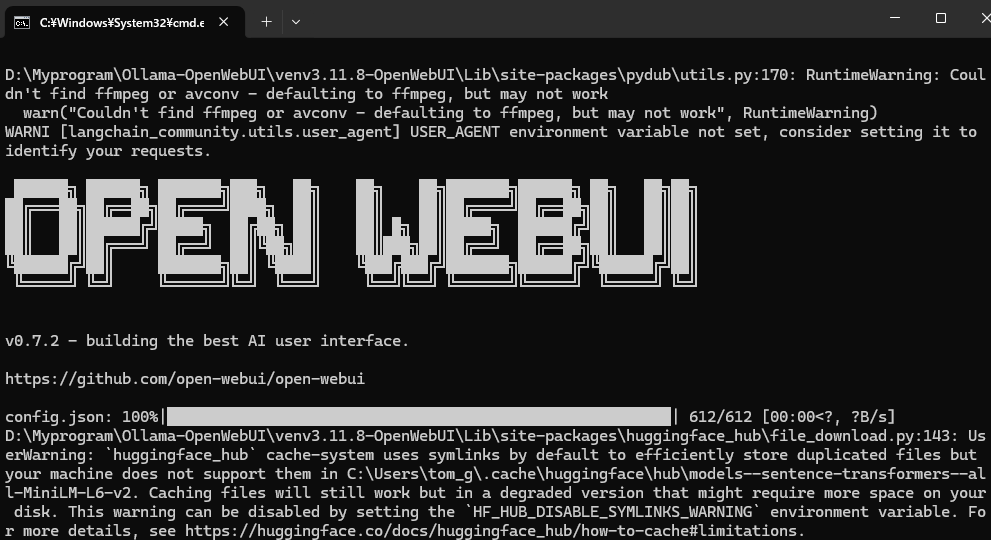

open-webui serve

しばらくすると、Open-WebUIの文字がでてきます。

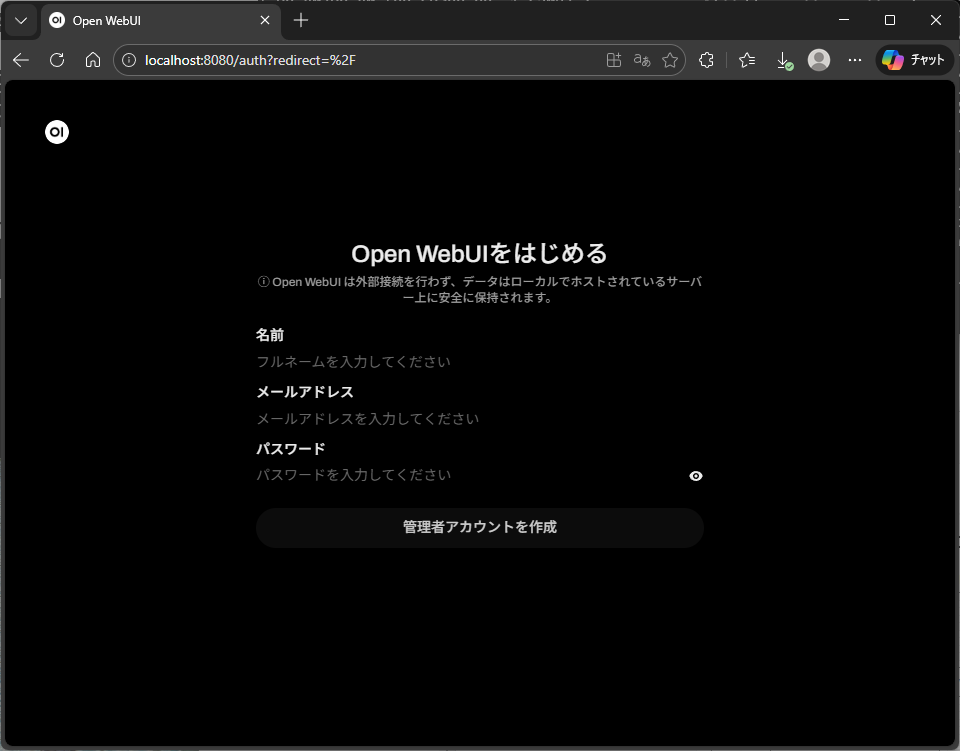

そうしたら、ブラウザに

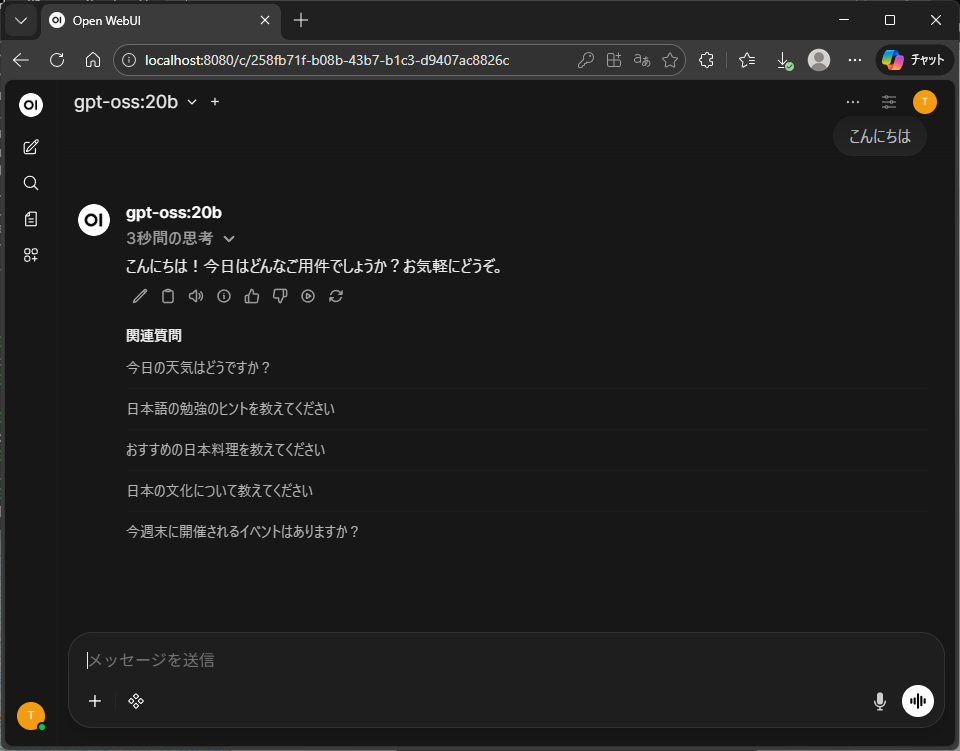

http://localhost:8080をうつと、こんな感じの画面が現れます。これが出たら、Open-WebUIは成功です。

「はじめる」をクリックすると、アカウント作成の画面になりますので、ご自身の名前を入れてアカウントを作成。

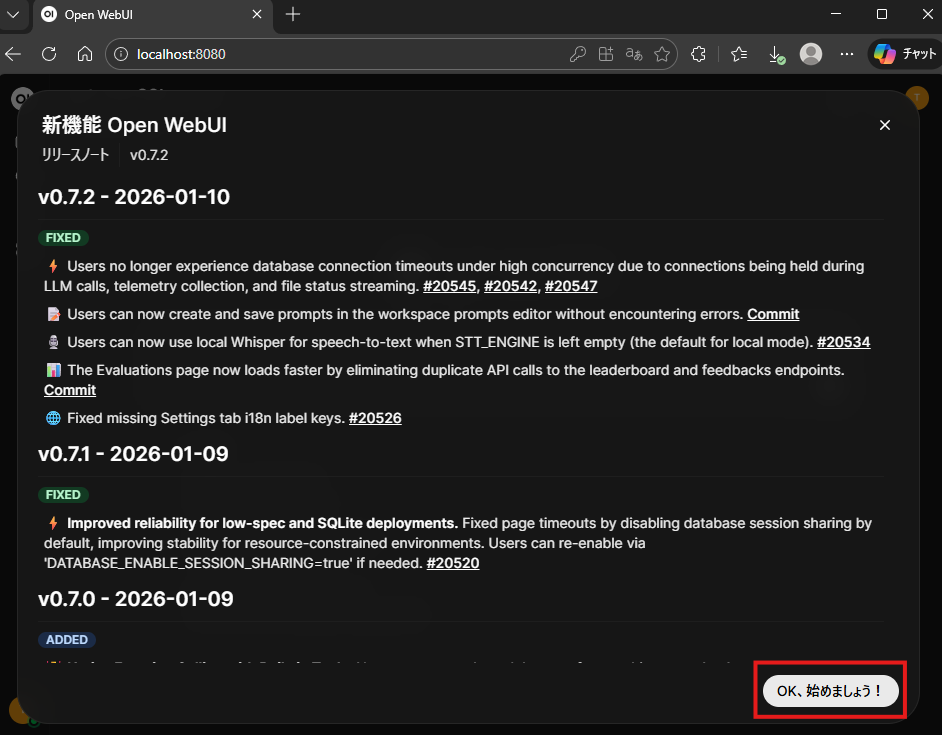

「OK、始めましょう」をクリック

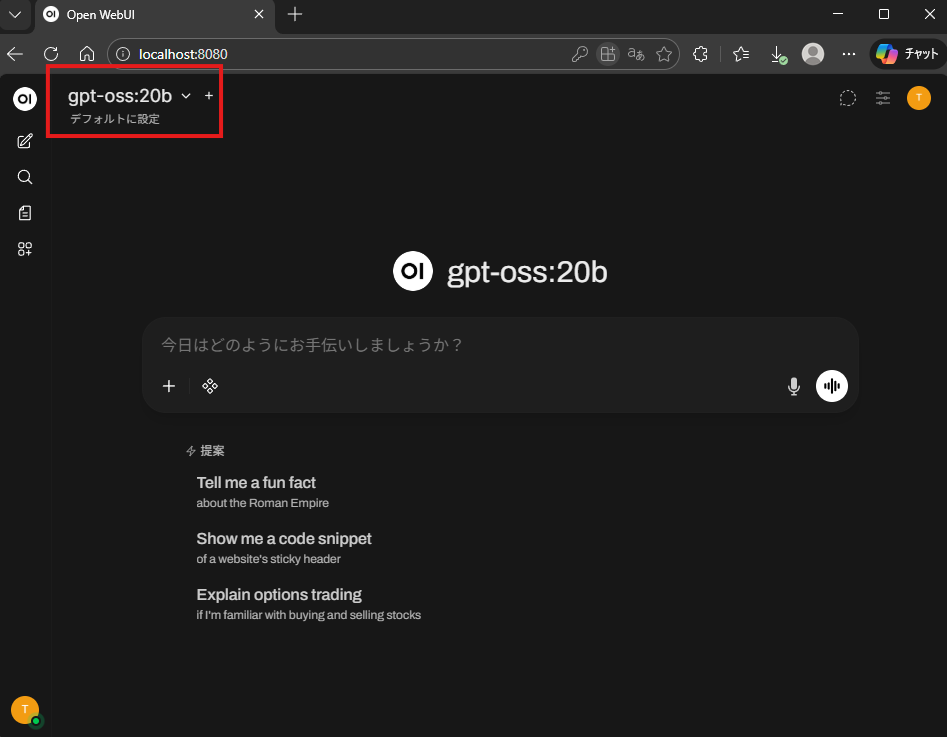

そうすると、先ほどOllama上でダウンロードしたモデルが左上に出ている事がわかると思います。こうなったら成功です。

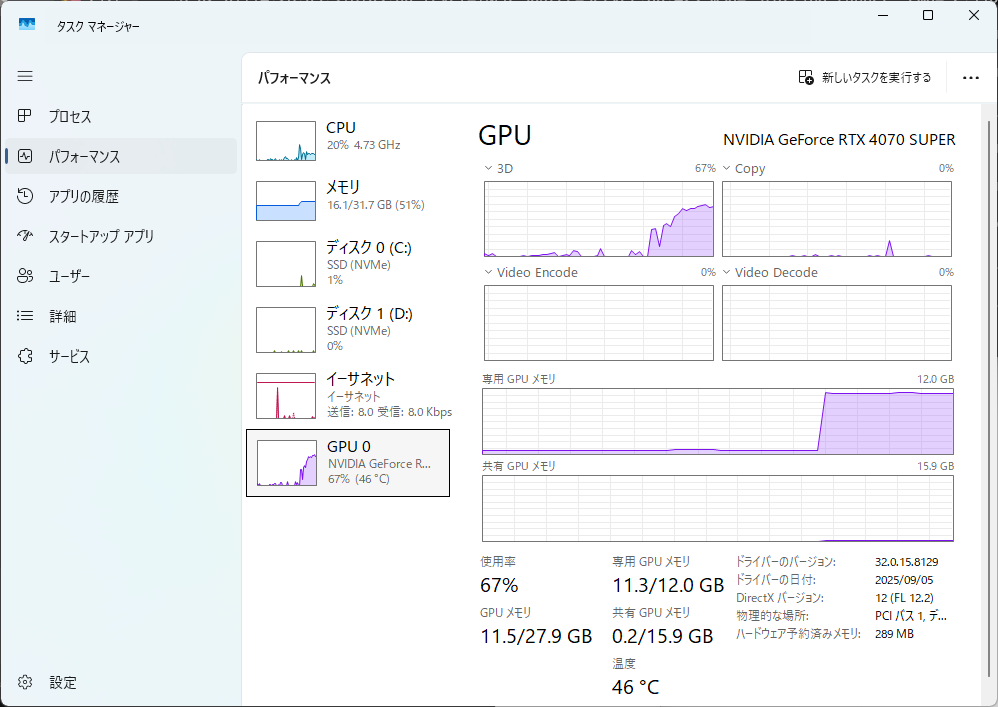

gpt-oss-20bですが、このRTX4070 SUPERではちょっと遅い感じがします。

GPUのメモリもがっつり使われていますね。

Open-webUIでローカルRAGを試す

それでは、社内ローカルチャットボットで一番やりたい、RAGの使い方を説明します。

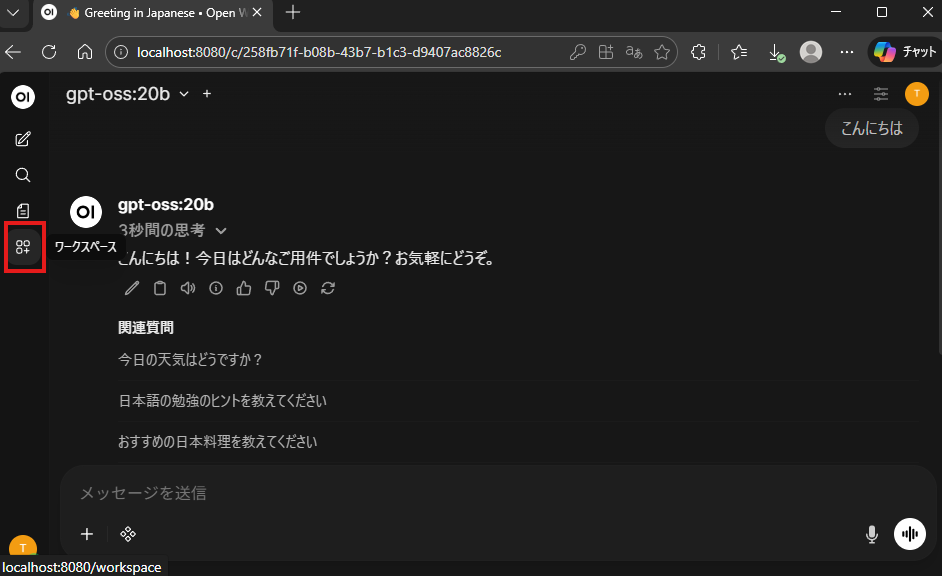

Open-WebUIの「ワークスペース」を選択

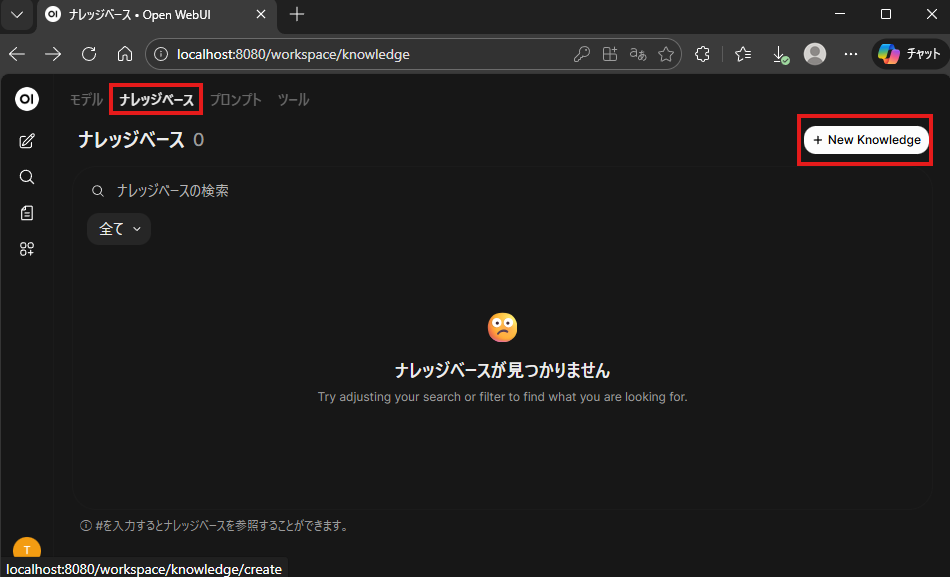

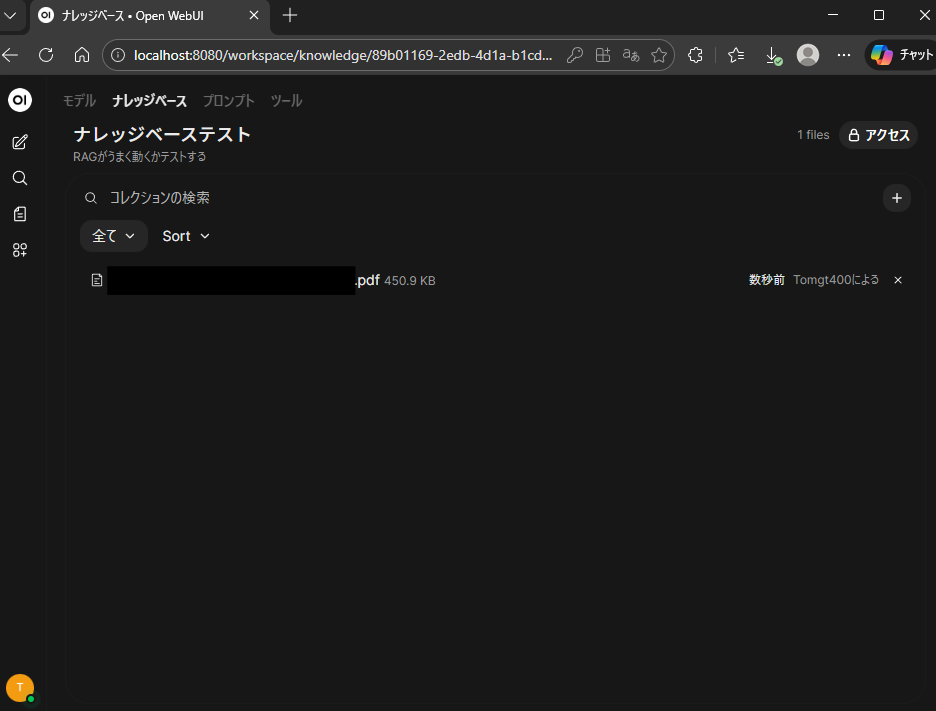

「ナレッジベース」→「New Knowledge」を選択

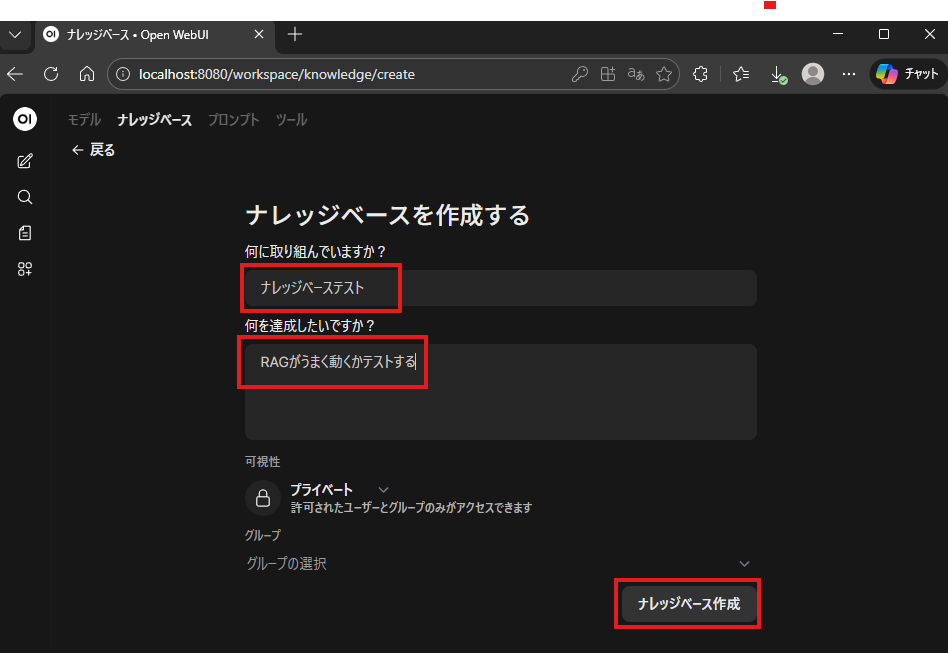

赤枠適当に入力し、「ナレッジベース作成」をクリック

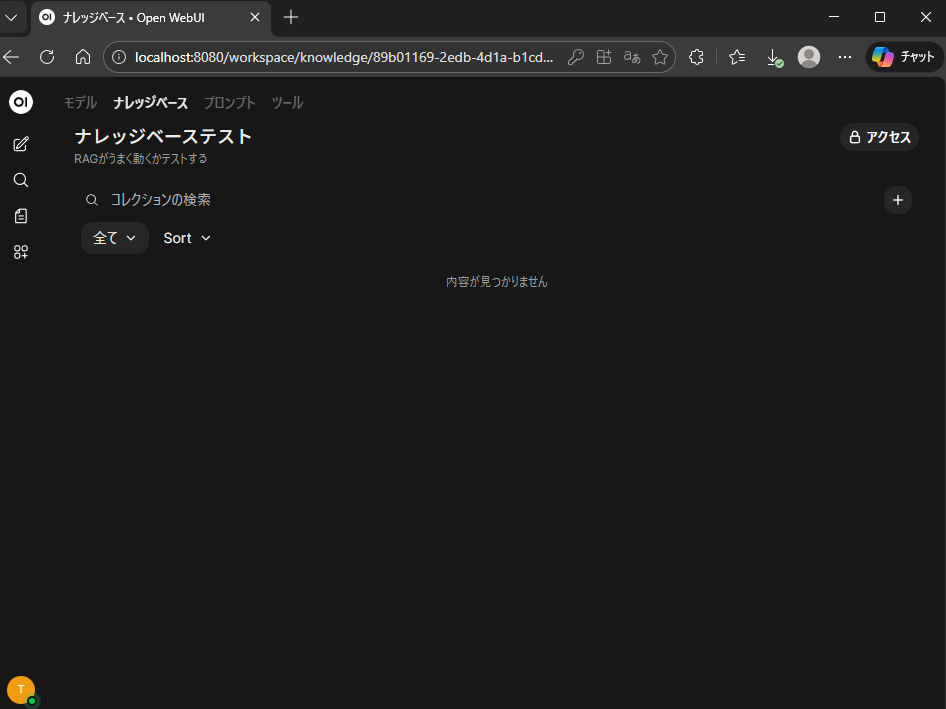

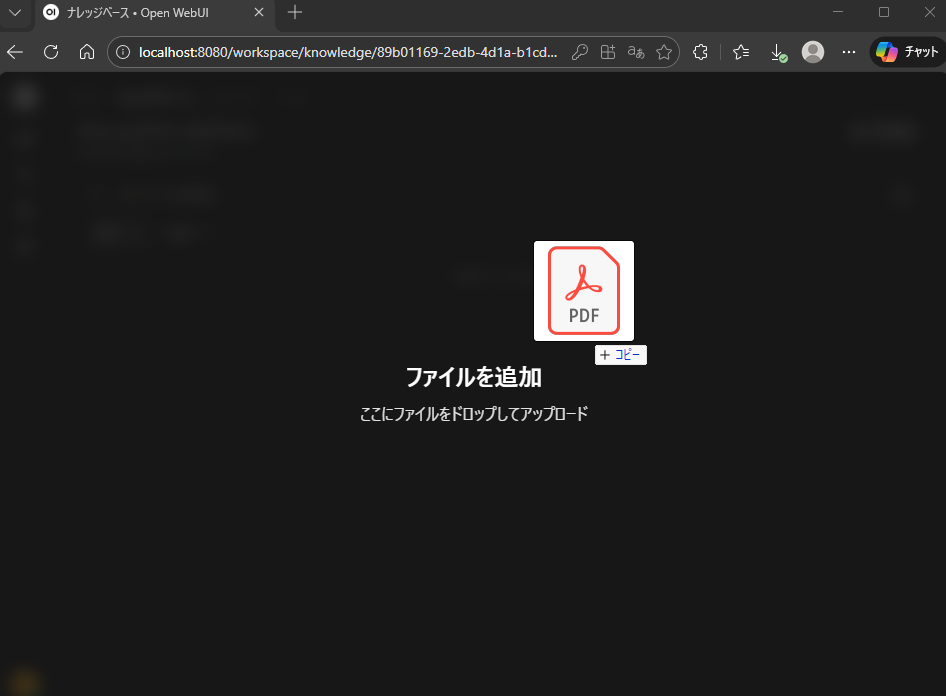

作成ボタンを押すと、このようになっていますので、RAGしたいファイルをドラッグ&ドロップします。

そうすると、ファイルが追加されます。

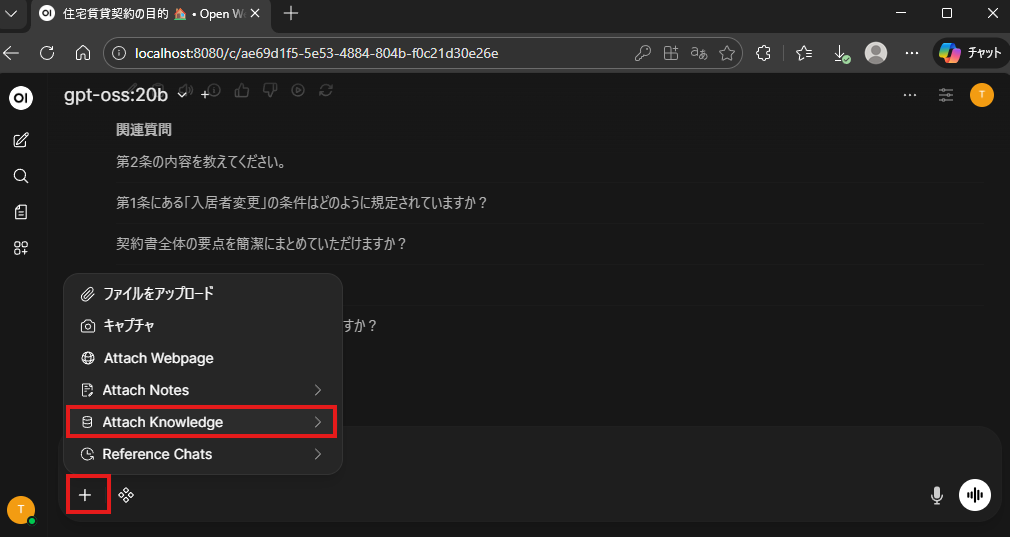

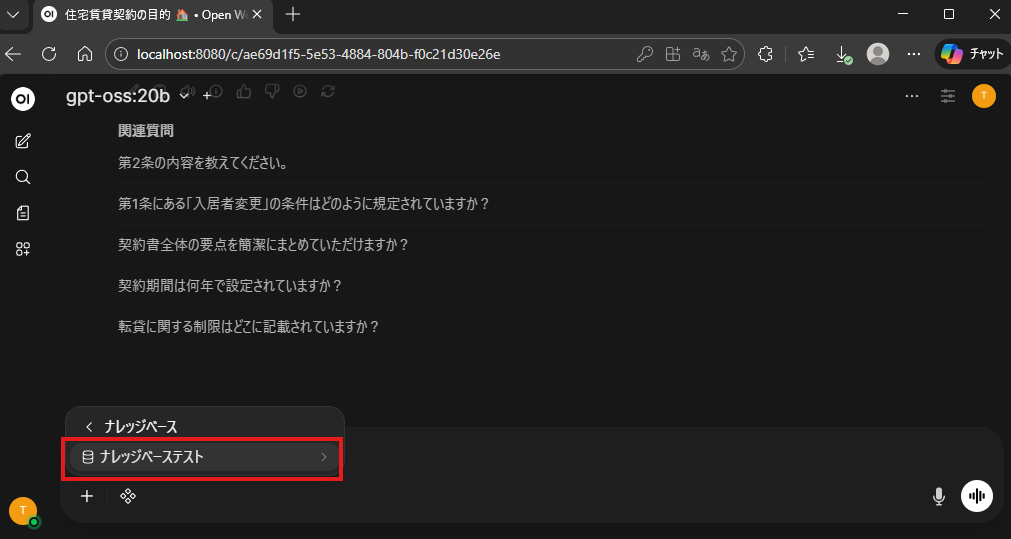

それでは取り込んだファイルの中身を聞いてみましょう。

先ほど作成した「ナレッジベース」を読みだすには、↓赤枠の「+」ボタンから「Attach Knowledge」を選択

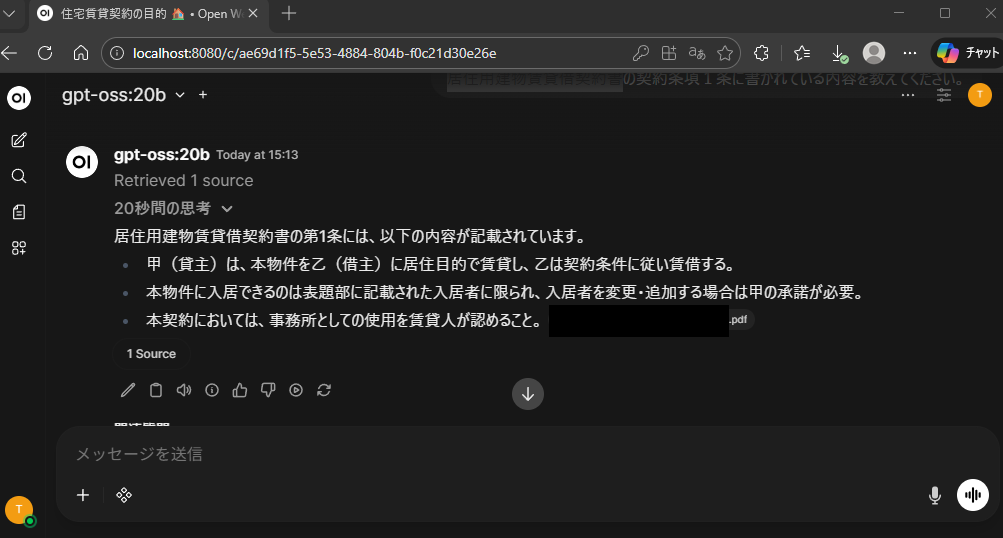

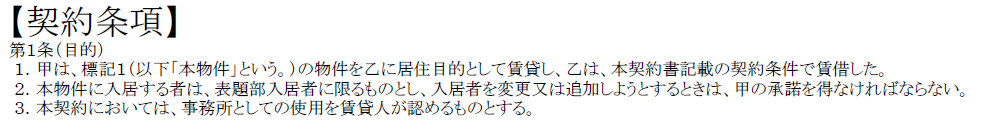

今回は居住用建物賃貸借契約書を読み込ませたのですが、「居住用建物賃貸借契約書の契約条項1条に書かれている内容を教えてください。」と聞いたところ、次のように使われたソースのファイル名がでて、回答もしてくれました。

実際に読ませたファイルの第1条は次の文章なので、文面は違えど、同じ事を言っているかと思います。RAGも簡単にできそうです。

まとめ

WIndows環境で、OllamaとOpen-webUIの組み合わせで簡単のローカルのチャットボットを作成する方法を記載しました。http://localhost:8080 のlocalhostの部分をこれが起動しているPCのIPアドレスに変えてあげれば、ネットワーク上の他のPCからもアクセスでき、簡単に皆が使うことでできます。

類似の記事の、LM-studioの記事は下記

コメント